KISEC

KI-Sicherheitssystem für 7-Achs-Roboter

Projektlaufzeit: 07/2019 - 12/2021

Ziel des Projektes ist es, ein Sicherheitssystem zu entwickeln, welches den Betrieb eines Industrieroboters außerhalb klassischer Roboterzellen absichert. Der Industrieroboter soll in einer Umgebung betrieben werden, in der sich Personen frei bewegen und sich Objekte befinden können. Das Sicherheitssystem soll Bewegungsfreiheit im Arbeitsraum erlauben und absichern. Kollisionen mit Personen oder Gegenständen sollen so verhindert werden.

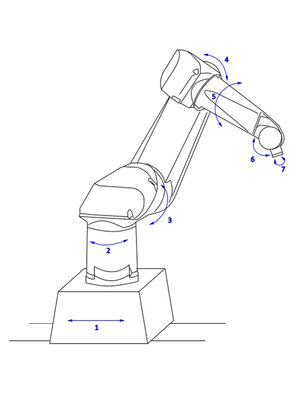

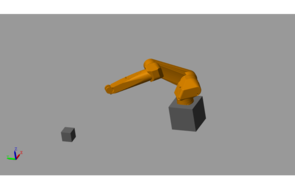

Der Industrieroboter ist auf einer zusätzlichen Achse verfahrbar [Verweis Bild 1]. Somit entsteht ein größerer Arbeitsraum und höhere Geschwindigkeiten als beim regulären Betrieb von Industrierobotern. Es ist von Geschwindigkeiten von bis zu 6m/s auszugehen. Diese Vorgaben stellen zusätzliche Anforderungen an das zu entwickelnde Sicherheitssystem.

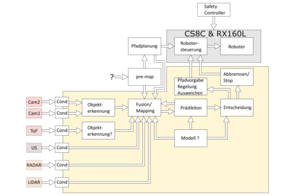

Um das Sicherheitssystem mit Daten zu versorgen, ist das Anbringen diverser Sensoren am Roboter geplant. Dabei sollen verschieden Sensorkonzepte eingesetzt werden, um von den unterschiedlichen Vorteilen diverser Sensoren (z.B. Geschwindigkeit, Auflösung) zu profitieren. Gewählte Sensoren sind Stereokameras, ToF Sensoren und LiDAR-Sensoren. Die durch die Sensoren erhobenen Daten müssen vorverarbeitet und fusioniert werden. Exemplarisch ist der Konzeptaufbau des Verarbeitungs- und Entscheidungssystems in Abbildung [Verweis Bild 2] zu sehen.

Arbeitsraumerfassung durch Spatial Mapping

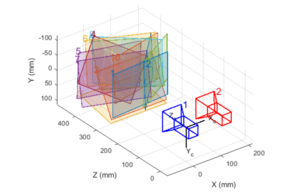

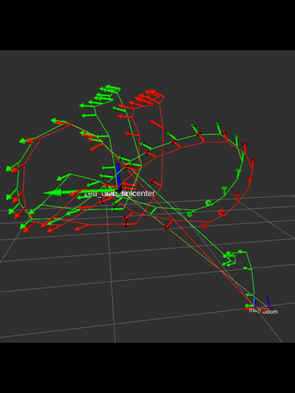

Die vorherige Erfassung des Arbeitsraums ist nötig, um Gefahrenbereiche definieren zu können und Verfahrwege des Roboterarms zu planen. Dies geschieht mit Hilfe von Spatial Mapping. Bei diesem Verfahren werden Einzelbilder der nebeneinander angeordneten Stereo-Kameras auf gemeinsame Punkte und deren Orientierung im Raum analysiert [Verweis Bild 3]. Anschließend werden diese Bilder an ihren gemeinsamen Punkten verbunden um eine dreidimensionale Karte der Umgebung anzufertigen [Verweis Bild 4].

Erfassung der Kamera-Bewegungen durch Spatial-Movement-Tracking

Die genaue Position der Kamera im Raum zu kennen, ist essentiell für die Berechnung der Positionen detektierter Objekte. Hier geschieht dies anhand von Beschleunigungssensoren und einem Magnetometer, welche sowohl die Orientierungs- als auch die Positionsänderung der Kamera tracken [Verweis Bild 5].

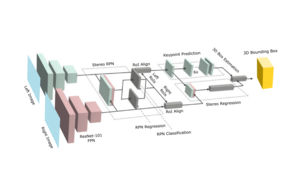

Personen-Erkennung und Tracking durch Mask RCNN in Stereo-Kamera-Bildern

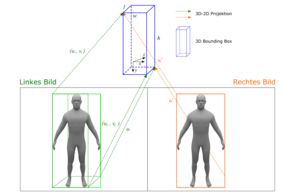

Die Bestimmung der Positionen von Menschen im Arbeitsraum erfolgt, indem trainierte neuronale Netze (basierend auf einem Mask RCNN) etwaig vorkommende Personen aus den Einzelaufnahmen der Stereo-Kamera-Bilder segmentieren [Verweis Bild 6]. Zusätzlich zur Erkennung und Zuordnung der gemeinsamen Punkte werden hierbei noch Informationen eines Tiefensensors genutzt um die Positionsbestimmung zu verbessern. Bereiche, in denen das neuronale Netz Personen detektiert, werden in Form von Bounding Boxen weitergegeben [Verweis Bild 7].

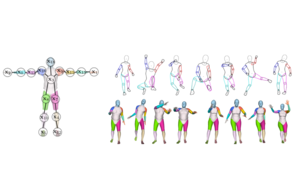

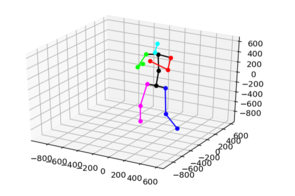

Bestimmung der Positionen von Gliedmaßen durch Pose-Estimation

Da bezogen auf Gliedmaßen unterschiedliche Sicherheitsbestimmungen gelten, ist es von Nutzen detektierte Personen in ihre Gliedmaßen aufzuschlüsseln. Dies geschieht mit Hilfe neuronaler Netze, welche auf diese Aufgabenstellung mit Hilfe von Motion-Capture-Verfahren trainiert wurden [Verweis Bild 8]. Damit ist es möglich, einem menschlichen Körper 25 vordefinierte Punkte zuzuordnen, deren Position im Raum für die Sicherheitsbewertung herangezogen werden kann [Verweis Bild 9].

Modellierung

Um Abstandsszenarien und Eingriffe in den geplanten Ablauf testen zu können, wird ein Modell erstellt, mit welchem Kinematik und Dynamik des Roboters sowie der Verfahrachse simuliert werden [Verweis Bild 10]. Hier können auch Hindernisse eingefügt werden, um ein Ausweichen zu simulieren.

Zielsetzung des Sicherheitssystems

Gefährdet die aktuell geplante Bewegung des Roboters eine Person, ist eine Kollision mit einem Gegenstand möglich? Diese Entscheidung soll das Sicherheitssystem aufgrund von dynamisch gefasste Grenzen treffen, entgegen üblichen festen Schutzgrenzen. Diese dynamisch gefassten Grenzen ergeben sich aus den Planungsdaten der Roboterfahrt, den aktuellen und erwarteten Positionen und Geschwindigkeiten des Roboters sowie der potentiellen Hindernisse im Arbeitsraum. Dabei soll automatisch entschieden werden, ob eine Kollision durch Abbremsen oder Auszuweichen oder die Bewegung einzelner Achsen verhindert werden kann. Das Sicherheitssystem soll dazu auf Methoden der künstlichen Intelligenz (KI) zurückgreifen.

Das Kooperationsprojekt wird mit der Ingenieurbüro Hannweber GmbH und der Firma Babelyou bearbeitet. Gefördert wird es durch die EFRE-Technologieförderung.

Kontakt

Projektleitung

Prof. Dr.-Ing. Jens Jäkel

Professur Systemtheorie und Mechatronik

Telefon: +49 (0)341 3076 1125

E-Mail: jens(dot)jaekel(at)htwk-leipzig.de

Ansprechpartner

M. Eng. Christian Rickert

Wissenschaftlicher Mitarbeiter

Telefon: +49 (0)341 3076 1164

E-Mail: christian(dot)rickert(at)htwk-leipzig.de